|

|

来历:知乎

布景

之前读过一篇文章:

NOSMOG: Learning Noise-robust and Structure-aware MLPs on Graphs

题目简洁了然,间接说出方式的名字与焦点进献,Noise-robust & Structure-aware ,方针是进修MLP on Graphs。看模板估量是NIPS模板。2022年8月挂到了Arxiv。

后来发现,这篇文章中了ICLR2023,题目改成了:

LEARNING MLPS ON GRAPHS: A UNIFIED VIEW OF EFFECTIVENESS, ROBUSTNESS, AND EFFICIENCY

23年1月21显现accept,而且还是 spotlight,前25%的文章。

所以就饶有爱好,想来对照一下这俩版本。

<hr/>根本常识

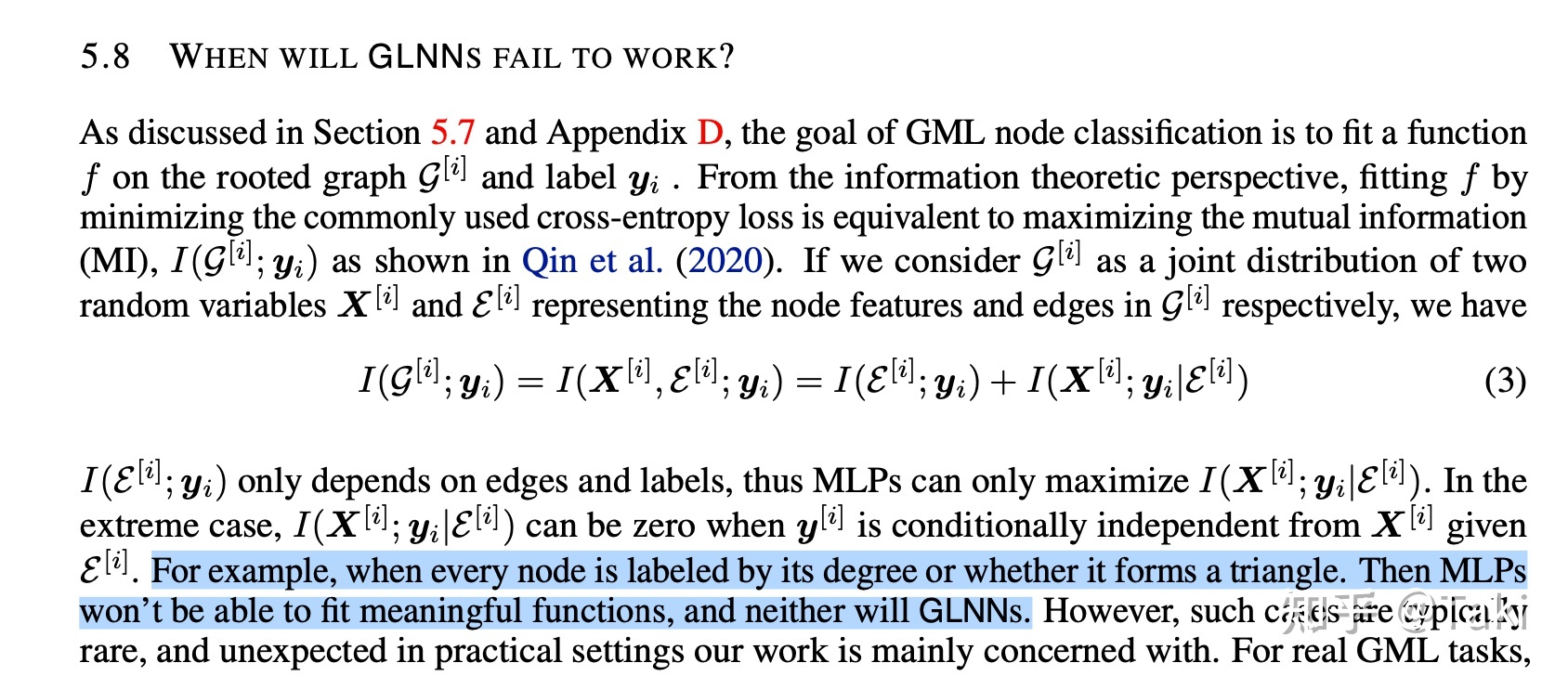

可以参考这篇论文:Graph-Less Neural Networks: Teaching Old MLPs New Tricks Via Distillation

更多关于GNN蒸馏到MLP的文章可以参考:

Graph-Less Neural Networks: Teaching Old MLPs New Tricks Via Distillation这篇论文中留了几个issue,有待前面的学者处理,就是:

1)MLPs cannot fully align the input content feature to the label space, especially when node labels are correlated with the graph structure;

2)MLPs rely on the teacher’s output to learn a strict hard matching, jeopardizing the soft structural representational similarity among nodes;

3)MLPs are sensitive to node feature noises that can easily destroy the performance

针对这三个题目,这篇NOSMOG提出的处理计划别离是:

1. 引入positional embedding,引入位置信息

2. 引入表征类似度这个量,从teacher蒸馏给student

3.引入匹敌进修,增强抗噪声才能

从方式的角度来看,中规中矩。这几个题目都是baseline论文中间接给出来的,然后一个萝卜一个坑,引入 位置信息(也就是结构信息),增强蒸馏的形式,加入匹敌进修等。重新奇度来看,新,可是没那末新。不外如果不懂Graph-Less Neural Networks: Teaching Old MLPs New Tricks Via Distillation这篇论文,以为这三个题目都是本文发现的,那末貌似本文的进献就很大了。

文章确切不错,能做成这样也还好。不外ICLR说的“opens the door”有点名过实在,过于歌颂了。(希望本文的作者看到这里不要骂我,我认可文章不错,可是审稿人+AC明显没读过Graph-Less Neural Networks: Teaching Old MLPs New Tricks Via Distillation,更没有读过我写的 Distill GNN to MLP博客。)

<hr/>看看写作

假定,我说假定,假定这篇是投了NIPS2022被拒,然后挂Arxiv,前面转投ICLR2023,然后23年1月中了。那末,最大的变量,不过就是写作技能。所以这里专门对照一下两篇稿子,看看到底有什么窍门。

题目

NOSMOG: Learning Noise-robust and Structure-aware MLPs on Graphs

-> LEARNING MLPS ON GRAPHS: A UNIFIED VIEW OF EFFECTIVENESS, ROBUSTNESS, AND EFFICIENCY 这俩题目都是好题目。

第一个 简单了然,很清楚,方式叫NOSMOG,特点是噪声鲁棒+结构(edge信息)感知,使命是MLP on Graph。这里还避免了利用Distillation词,错位合作,省得大师都去关注Graph-Less Neural Networks: Teaching Old MLPs New Tricks Via Distillation这篇论文。

第二个题目,方式还是阿谁方式,可是叙事观更宏大了。上代价观了!一样,避免出现Distillation这个词,间接夸大重点处理的三个题目:effecttiveness,ROBUSTNESS,EFFICIENCY。不外这里的 UNIFIED VIEW我是不太懂,整篇文章都没诠释什么是UNIFIED VIEW。(正文只出现了一次:In this paper, we address three significant issues of existing GNNs-MLPs frameworks and present a unified view of learning MLPs with effectiveness, robustness, and efficiency. )这么看来,三个题目打包一下,取一个新名字,这就是 UNIFIED VIEW。

简单来说就是:

咱俩关系很好!-> We are family, bro 升华了,升华了

摘要

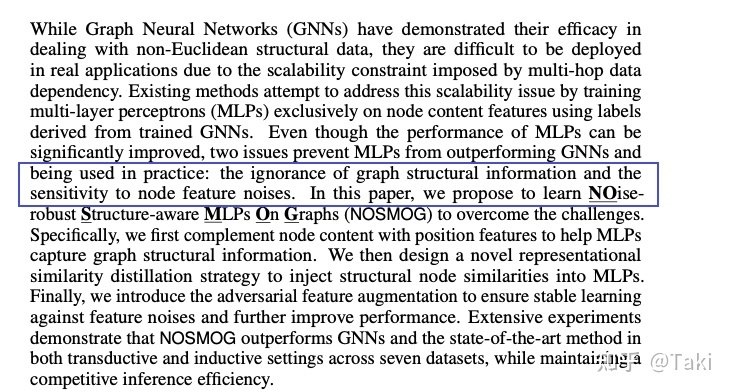

旧的:

中规中矩,GNN很好,可是推理慢 -> 很多人用MLP取代GNN -> MLP存在两个题目,1 没有结构信息 2 不够鲁棒,不抗噪 -> 我们提出了NOSMOG处理这俩issue -> 尝试证实有用性。

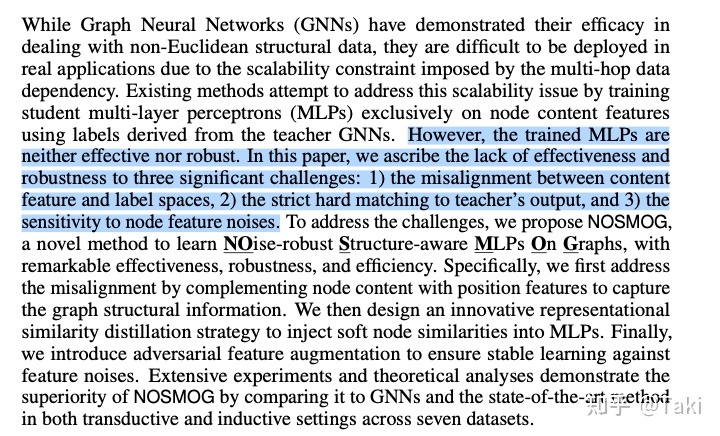

我们再来看看新版本:

这里照应了题目。

GNN很好,可是推理慢 -> 很多人用MLP替换GNN -> MLP不够有用,不够鲁棒 -> 由于现在的KD这类做法存在几个题目,1) the misalignment between content feature and label spaces, 2) the strict hard matching to teacher’s output, and 3) the sensitivity to node feature noises. -> 我们提出了NosMog来处理这些题目 -> 尝试证实有用性。

相比第一版,这里加倍突出了 why old methods fail,读起来感觉加倍清楚旧方式的题目地点。同时,也点出了NOSMOG的具体改良偏向:EFFECTIVENESS, ROBUSTNESS。 此外题目里面还有EFFICIENCY,这是MLP取代GNN的Motivation。

简介

这块修改不大。不外这文章的Contribution我想吐槽一下:

这几个题目,是您发现的么?

我们看看GLNN的文章,https://arxiv.org/pdf/2110.08727v2.pdf,便可以发现:

除了这两个点之外,原作者还送了两个点:

(不外一些后续文章也研讨了这俩题目,比如TEACHING YOURSELF: GRAPH SELF-DISTILLATION ON NEIGHBORHOOD FOR NODE CLASSIFICATION)

固然,假如写成是他人发现的题目,这篇文章仅仅处理题目,显得太low。所以本文的写法,让人感觉是本文发现了这俩题目,用以增加卖点。

前面的内容就无区分了,这里就差池比了。

<hr/>结论

毫无疑问,人是衣装,佛是金装。

一件事自己就具有各类角度,各类看法。正所谓,横看成岭侧成峰。

从写作的角度看,第一是清楚,

处理了什么题目?干了什么事?怎样实现的?现实结果好欠好?能否是由于这个才进步的结果? 第二就是代价观,登科了这篇文章,对他人能有什么启发?这件事有多大的意义?

保举一些材料:

无妨好好读一读刘洋教员的PPT。

原文地址:https://zhuanlan.zhihu.com/p/608722606

免责声明:

1、文章部分图片源于收集,均为表示图;

2、一切文章、图片、音频视频文件等材料版权归版权一切人一切;

3、因非原创文章及图片等内容没法和版权者联系,如原作者或编辑以为作品不宜上网供阅读,或不应无偿利用,请实时告诉我们,以敏捷采纳适当办法,避免给双方形成不需要的经济损失;

4、本页面内容由爬虫法式自动收集于互联网,如无意中加害了媒体或小我的常识产权,请电邮【E-Mail:cb@yoyodoc.com】告之,我们将于24小时内删除。 |

|

|Archiver|手机版|小黑屋|小悠文档创作分享社区

( 粤ICP备11072215号 )|网站地图

|Archiver|手机版|小黑屋|小悠文档创作分享社区

( 粤ICP备11072215号 )|网站地图